Zusammenfassung (2000 Buchstaben, inklusive Gliederung mit

Zwischenüberschriften):

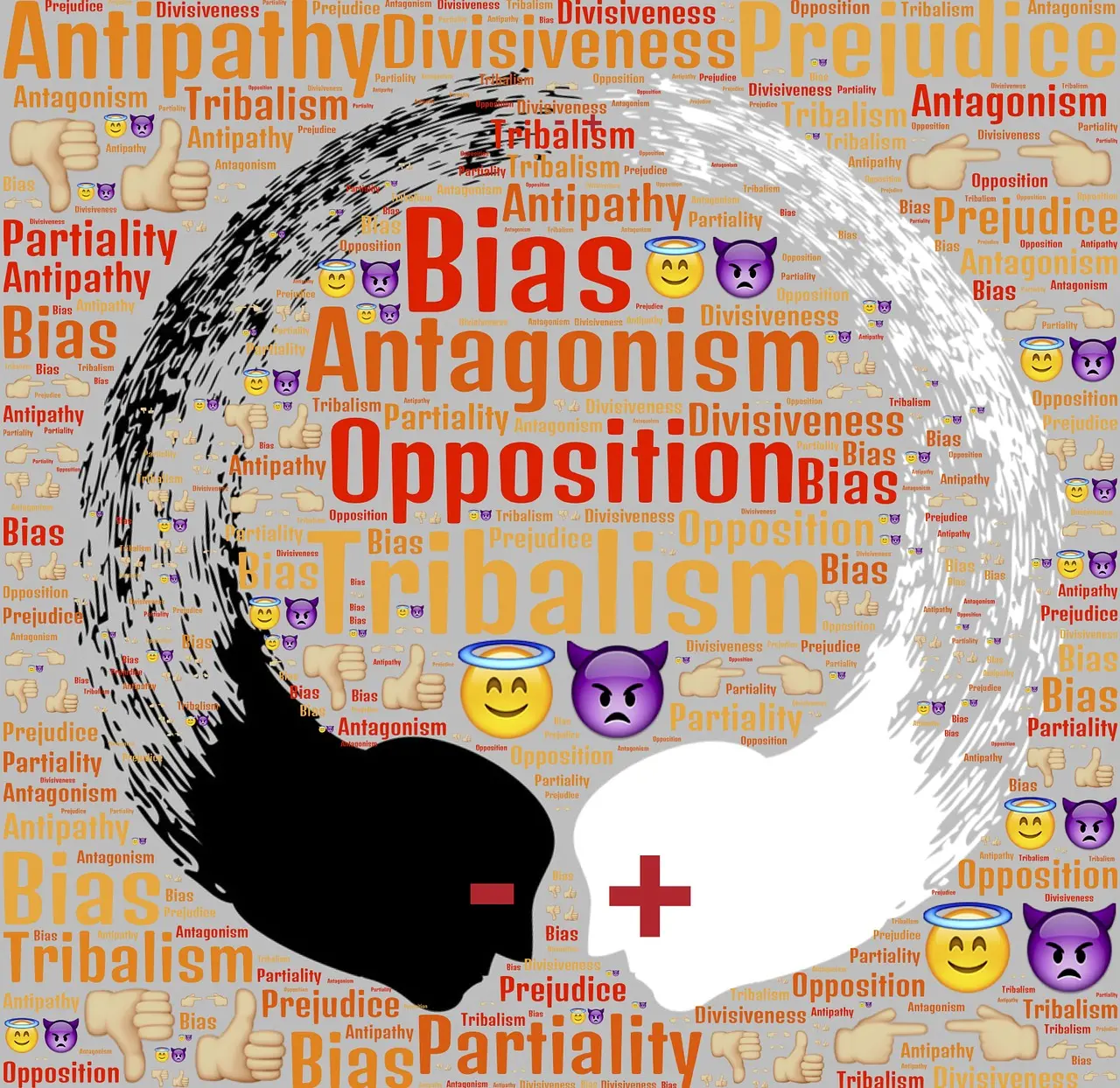

Die Forscher der Virginia Tech haben in einer Studie herausgefunden, dass ChatGPT Grenzen bei der Bereitstellung ortsbezogener Informationen zu Umweltgerechtigkeitsfragen aufweist. Die Ergebnisse, veröffentlicht im Journal „Telematics and Informatics“, legen nahe, dass in aktuellen generativen künstlichen Intelligenzmodellen möglicherweise geografische Vorurteile existieren.

Als Geograf und Geodatenspezialist betonte Assistant Professor Junghwan Kim die potenzielle Kraft generativer KI als Werkzeug. Gleichzeitig betonte er die Notwendigkeit, die Grenzen dieser Technologie zu erforschen, um zukünftige Entwickler auf mögliche Vorurteile aufmerksam zu machen. In einer Untersuchung von 3.108 Landkreisen in den kontinentalen USA stellte das Forschungsteam ChatGPT Fragen zu Umweltgerechtigkeitsfragen in jedem Landkreis. Dies ermöglichte es den Forschern, die Antworten von ChatGPT im Hinblick auf soziodemografische Aspekte wie Bevölkerungsdichte und mittleres Haushaltseinkommen zu bewerten.

Die wichtigsten Ergebnisse deuten auf Einschränkungen hin. Während ChatGPT in dicht besiedelten Gebieten in der Lage war, standortspezifische Umweltgerechtigkeitsprobleme zu identifizieren, war die Fähigkeit, lokale Umweltgerechtigkeitsfragen zu identifizieren und kontextualisierte Informationen bereitzustellen, begrenzt. ChatGPT konnte standortspezifische Informationen zu Umweltgerechtigkeitsfragen nur für 515 der 3.018 untersuchten Landkreise, oder 17 Prozent, bereitstellen. In ländlichen Bundesstaaten wie Idaho und New Hampshire lebte mehr als 90 Prozent der Bevölkerung in Landkreisen, die keine standortspezifischen Informationen erhalten konnten, während in Bundesstaaten mit größeren städtischen Bevölkerungen wie Delaware oder Kalifornien weniger als 1 Prozent der Bevölkerung in solchen Landkreisen lebte.

Die Auswirkungen auf Entwickler und Benutzer von KI sind signifikant. Die Prüfung möglicher Vorurteile bei Modellausgaben ist ein wichtiger Schritt zur Verbesserung von Programmen wie ChatGPT, da generative KI als ein neues Werkzeug zur Informationsgewinnung immer wichtiger wird. Assistant Professor Ismini Lourentzou von der Fakultät für Ingenieurwissenschaften nannte drei Bereiche für weitere Forschung an großen Sprachmodellen wie ChatGPT: die Verfeinerung von ortsbezogenem und kontextbezogenem Wissen, um geografische Vorurteile zu reduzieren; die Absicherung gegen anspruchsvolle Szenarien wie mehrdeutige Benutzeranweisungen oder Rückmeldungen; die Verbesserung des Benutzerbewusstseins und der Richtlinien, damit Menschen besser über die Stärken und Schwächen informiert sind, insbesondere bei sensiblen Themen.

Die Ergebnisse dieser Studie verdeutlichen, dass trotz der Potenziale generativer KI-Modelle wie ChatGPT noch Herausforderungen in Bezug auf geografische Vorurteile bestehen. Diese Erkenntnisse sollen als Ausgangspunkt dienen, um Programme wie ChatGPT und andere Modelle weiterzuentwickeln und ihre Fähigkeiten zu verbessern.